A Microsoft divulgou recentemente o resultado das suas pesquisas de IA para conversão de textos escritos em áudios personalizados, e pode imitar a voz de qualquer um. A partir de um breve áudio de 3 segundos, a ferramenta consegue simular a voz de qualquer pessoa ditando qualquer texto.

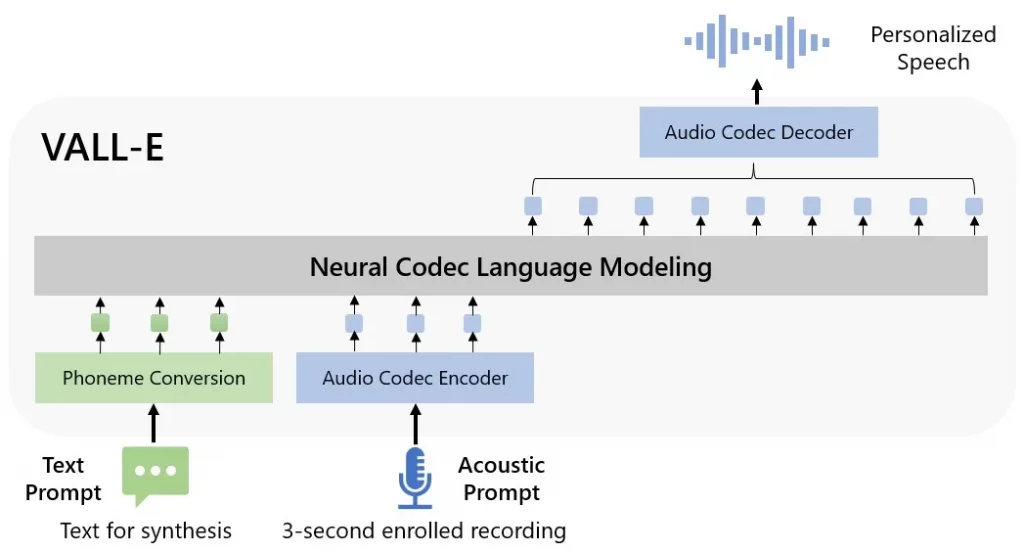

O novo recurso de IA foi batizado de VALL-E, e segundo a Microsoft é “um modelo de linguagem de codec neural”. Além de conseguir reproduzir a voz e o timbre de qualquer pessoa em qualquer comando, o software também preserva o tom emocional e a acústica do ambiente, como no áudio original.

Leia mais:

- Além dos charutos: Gangue cubana lucrou mais de US$ 60 milhões com ransomware em 2022

- São Francisco aprova o uso de robôs assassinos pela polícia

- Notion lança recurso de inteligência artificial que escreve textos e listas de tarefas

O modelo de codec usado no VALL-E é uma variável do Encodec, a rede neural alimentada por inteligência artificial desenvolvida pela Meta.

Em um artigo, os pesquisadores do projeto contam como foi a experiência de treinar o recurso com 60 mil horas de fala (em inglês) de mais de 7.000 usuários na biblioteca de áudio da Meta (LibriLight).

IA testada e comprovada no VALL-E Github

Além disso, os desenvolvedores do projeto lançaram um site exemplificando modelos de linguagem dos sintetizadores de textos, com amostras de falas e comparativo entre os áudios originais e a versão criada pela IA. Você pode acessar o site aqui.

O site detalha, em exemplos práticos, como é feita a manutenção da acústica do ambiente e o processo de decupagem até a recriação da voz artificialmente, em alguns casos, em mais de um exemplo. Além disso, ele também mostra exemplos da mesma frase sendo dita pela mesma voz, mas com emoções diferentes, que vão desde raiva até uma entonação de nojo.

VALL-E não terá acesso público

A nova IA da Microsoft não poderá ser acessada por qualquer um. Os desenvolvedores decidiram manter essa ferramenta privada, muito por conta dos riscos de uso indevido (como em casos de falsidade ideológica). Assim, a empresa ajuda a prevenir eventuais problemas de segurança pública que poderiam surgir a partir de áudios falsos feitos com o novo recurso.

Via Engadget

Imagem: Olena.07 (Shutterstock)

Já assistiu aos novos vídeos no YouTube do Olhar Digital? Inscreva-se no canal!