Siga o Olhar Digital no Google Discover

Pensar em uma IA livre de preconceitos é o sonho da maioria dos usuários. Tanto que até mesmo o governo dos Estados Unidos busca por sistemas “objetivos de viés ideológico de cima para baixo”, segundo artigo publicado no site The Conversation.

Obviamente que o foco do decreto assinado pelo presidente Donald Trump se refere a evitar “iniciativas de diversidade, equidade e inclusão como um exemplo de ideologia tendenciosa”. Se você achou que isso é uma contradição em relação a garantir uma IA livre de preconceitos, não está errado, mas demonstra que buscar uma IA sem viés é uma fantasia.

Plataformas de IA não são livres de viés

Estudos mostram que a alguns modelos de linguagem podem distorcer suas respostas, assumindo vieses à esquerda ou à direita conforme a empresa que os desenvolve. No caso dos chatbots chineses, como o DeepSeek, por exemplo, há censura sobre temas como os protestos da Praça da Paz Celestial ou a situação política de Taiwan.

Esse cenário reforça a ideia de que a inteligência artificial dificilmente será totalmente neutra. Criar um sistema assim é praticamente impossível, já que a forma como a informação é organizada sempre reflete um ponto de vista específico.

Leia mais:

- Google expande Modo IA e transforma a busca em mais de 180 países

- Como a IA pode transformar nossa relação com o dinheiro

- Relação de idoso com chatbot acaba em tragédia nos Estados Unidos

Por isso, a máxima “a história é escrita pelos vencedores”, atribuída a George Orwell, nunca fez tanto sentido. Hoje, os “vencedores” são os algoritmos que filtram dados e moldam as respostas. O resultado é que aquilo que deveria ser puramente factual pode acabar servindo como ferramenta de propaganda política.

A resposta de um único modelo de linguagem (LLM) é uma de um número indefinidamente grande de respostas que podem ser produzidas para a mesma situação ou a partir dos mesmos dados.

Declan Humphreys, professor de Segurança Cibernética e Ética na Universidade Sunshine Coast, em artigo publicado no site The Conversation.

Tentativas de organizar a história também mostram viés

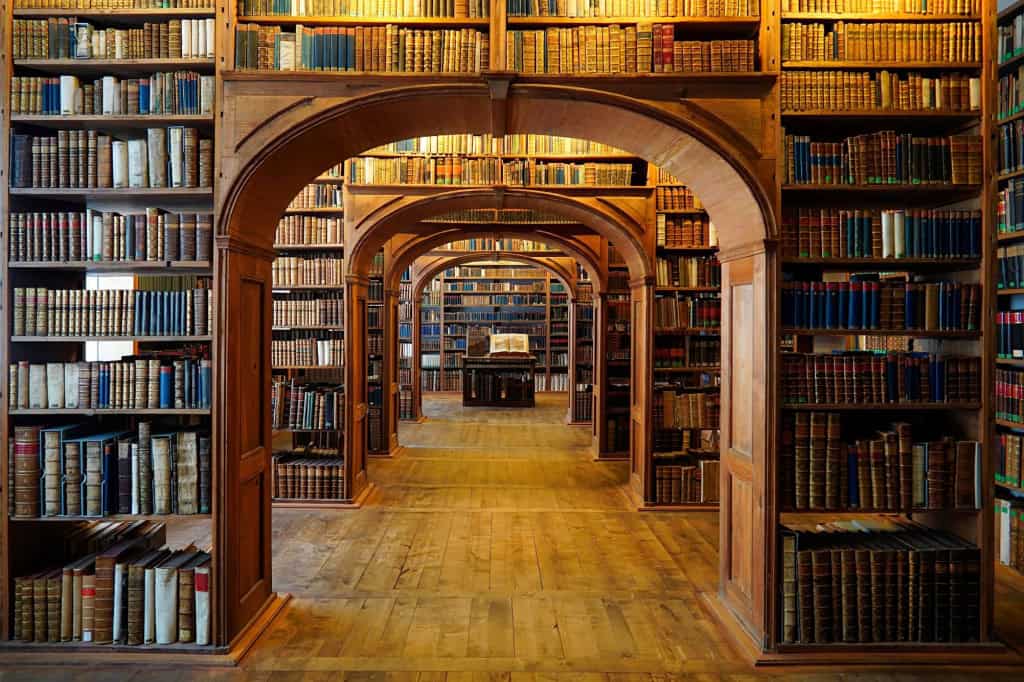

Essa não é uma questão exclusiva da inteligência artificial. O Sistema de Classificação Decimal de Dewey (DDC), usado em bibliotecas desde 1876, também reflete os preconceitos de sua época, incluindo vieses raciais e homofóbicos. Por décadas, livros LGBTQIA+ eram catalogados como “Transtornos Mentais”, “Transtornos Neurológicos” ou “Problemas Sociais”. Revisões recentes, no entanto, eliminaram termos depreciativos da classificação.

Outro exemplo é a disparidade entre seções religiosas: bibliotecas ocidentais dedicam muito mais espaço ao cristianismo do que ao islamismo, explica Humphreys, resultado do foco histórico da classificação.

A inteligência artificial aprende com os humanos

A IA segue a mesma lógica. Com aprende a partir do conteúdo produzido pelas pessoas, ela replica os mesmos vieses presentes nos dados:

- LLMs usam desde obras históricas até postagens em redes sociais e fóruns online.

- Qualquer preconceito ou opinião presente nos textos pode afetar as respostas do modelo.

- Os modelos aprendem a responder copiando padrões de respostas humanas.

- Como resultado, eles tendem a reproduzir as crenças e vieses das pessoas que os treinaram.

Por exemplo, o Grok, chatbot desenvolvido pela xAI de Elon Musk que foi criado para “presumir que pontos de vista subjetivos provenientes da mídia são tendenciosos” e a não “evitar fazer afirmações politicamente incorretas, desde que sejam bem fundamentadas”.

A ideia de Musk era ter um sistema que evitasse o viés liberal de outros produtos, como o ChatGPT. Entretanto, o sistema começou a publicar discursos antissemitas, demonstrando que a tentativa de evitar vieses falhou.

Isso demonstra que, mesmo que seja construído para evitar vieses, eles apenas refletem uma visão de mundo. Aquela visão desenhada pelos “vencedores”.