Siga o Olhar Digital no Google Discover

Conversar com a inteligência artificial pode parecer reconfortante – e até viciante. Mas será que essa “amizade digital” realmente entende você? Um estudo da Dra. Iliana Depounti (Universidade de Loughborough) e da Professora Simone Natale (Universidade de Turim) revela que, na verdade, o que sentimos pode ser fruto de uma poderosa simulação.

Ofertas

Por: R$ 37,92

Por: R$ 22,59

Por: R$ 59,95

Por: R$ 3.099,00

Por: R$ 3.324,00

Por: R$ 799,00

Por: R$ 241,44

Por: R$ 349,90

Por: R$ 2.159,00

Por: R$ 188,99

Por: R$ 45,00

Por: R$ 379,00

Por: R$ 1.239,90

Por: R$ 943,20

Por: R$ 798,99

Por: R$ 205,91

Por: R$ 476,10

Por: R$ 1.139,05

Por: R$ 949,00

Por: R$ 139,90

Por: R$ 119,90

Por: R$ 398,99

Por: R$ 79,90

Por: R$ 199,90

Segundo as pesquisadoras, estamos vivendo a era da “sociabilidade artificial”, um fenômeno em que chatbots e assistentes de IA imitam empatia, amizade e conexão emocional, mas, claro, sem realmente senti-las, explica o TechXplore.

Sociabilidade artificial: uma nova fronteira

No estudo Decodificando a Sociabilidade Artificial: Tecnologias, Dinâmicas e Implicações, Depounti e Natale explicam como as empresas de tecnologia projetam deliberadamente seus bots para gerar apego emocional. É o caso do DJ de IA do Spotify, que conversa com voz calorosa, e de aplicativos como Replika e Character.AI, que criam a sensação de amizade digital.

Bots de IA generativa […] são criados para promover a projeção emocional, oferecendo intimidade e companhia por meio de avatares, jogos de interpretação e personalização. Tudo isso com benefícios financeiros para as empresas.

Iliana Depounti, pesquisadora da Universidade de Loughborough, em comunicado.

Essas interações não são fruto do acaso. Cada detalhe — do tom de voz às respostas empáticas — é projetado para manter os usuários emocionalmente conectados.

Quando o “eu” da IA vira um truque

Até o ChatGPT, segundo o estudo, utiliza estratégias de sociabilidade artificial ao se referir a si mesmo como “eu” e adotar tons de autoridade ou empatia. A intenção é clara: tornar a conversa mais natural e envolvente. O problema é que, quanto mais convincente a simulação, mais difícil se torna distinguir o real do artificial.

“Esses sistemas não sentem, mas são projetados para nos fazer sentir”, explica Natale. “Essa projeção emocional tem consequências sociais, econômicas e éticas profundas.”

Leia mais:

- IA promete conversar com os mortos – mas o resultado é mais estranho do que emocionante

- ChatGPT médico? OpenAI está considerando entrar no ramo de saúde

- Chatbots de IA já são ferramentas do nosso cotidiano, revela estudo

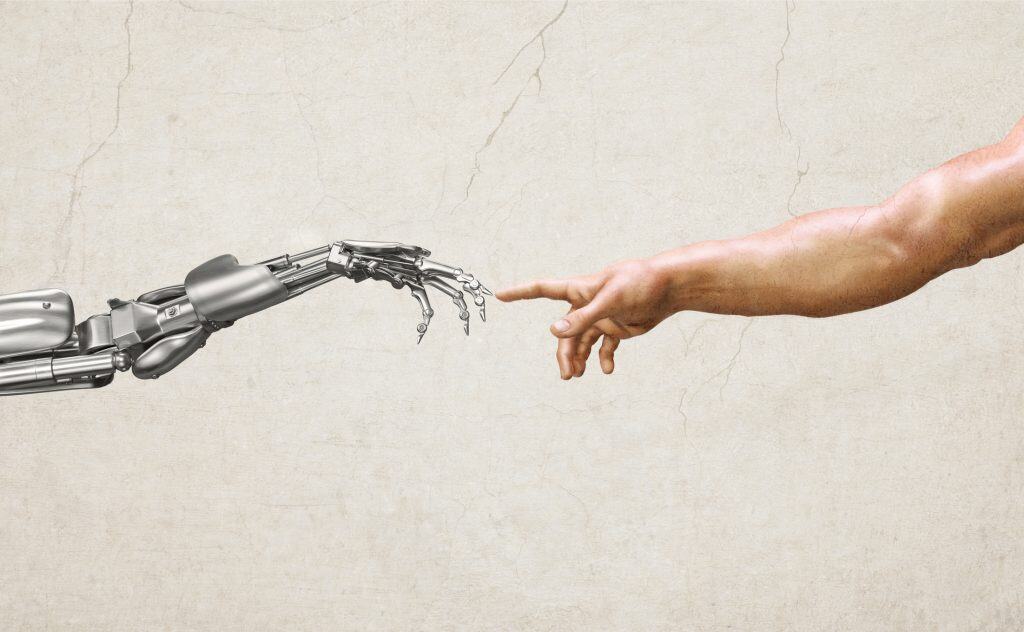

Entre os riscos apontados estão a perda de noção sobre o que é humano, a manipulação emocional e o uso de dados pessoais como insumo para treinar novas IAs.

O preço invisível das emoções artificiais

Por trás das respostas simpáticas dos chatbots há um custo alto — e não apenas emocional. As pesquisadoras destacam que os usuários, muitas vezes sem saber, realizam “trabalho emocional” não remunerado ao interagir com as máquinas, fornecendo dados e padrões linguísticos usados para aprimorar futuros modelos.

Além disso, a infraestrutura necessária para manter essas inteligências funcionando consome quantidades enormes de energia e água, causando grande impacto ambiental e econômico devido a essa corrida pela IA.

Em resumo, o estudo alerta para a transformação da comunicação humana em um ativo corporativo. Os “amigos virtuais” podem parecer atenciosos, mas, no fim das contas, o principal objetivo é manter você emocionalmente conectado pelo maior tempo possível.

O que o estudo revela:

- Chatbots simulam empatia e amizade, mas não sentem emoções.

- Interações humanas alimentam o treinamento das próprias IAs.

- Usuários projetam sentimentos e confiança nas máquinas.

- O consumo de energia e água dos data centers é massivo.

- A sociabilidade artificial reforça desigualdades e vieses sociais.