Siga o Olhar Digital no Google Discover

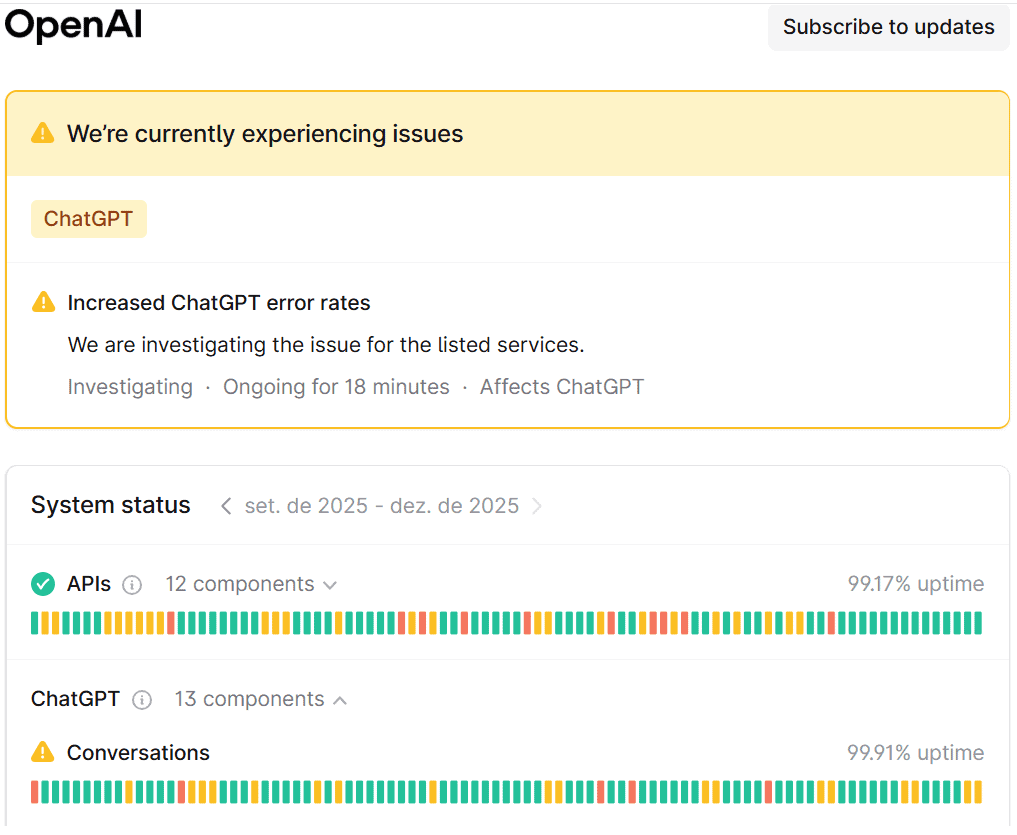

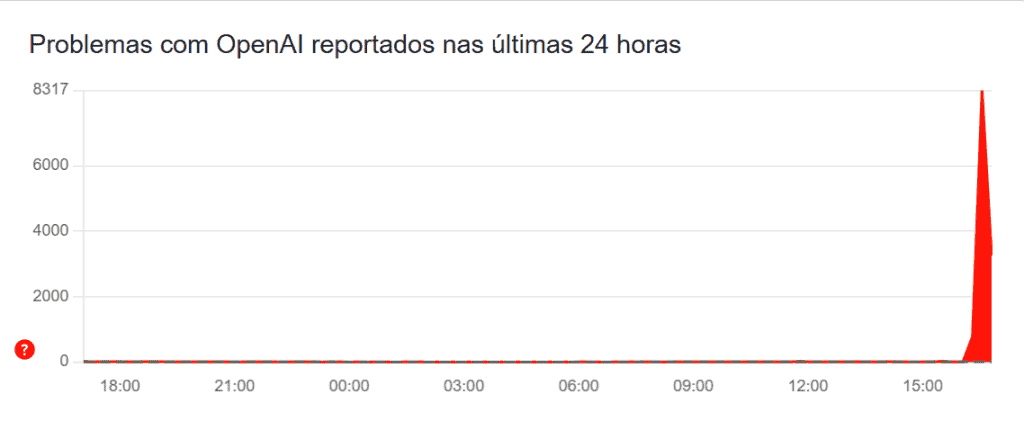

Na tarde desta quarta-feira (2), o ChatGPT começou a passar por problemas relacionados às interações com usuários. Por volta das 15h45 (horário de Brasília), o número de reclamações no Downdetector (site que contabiliza reportes de falhas) passou dos seis mil.

Ofertas

Por: R$ 4,66

Por: R$ 241,44

Por: R$ 241,44

Por: R$ 3.799,00

Por: R$ 2.083,16

Por: R$ 899,00

Por: R$ 889,00

Por: R$ 79,90

Por: R$ 59,90

Por: R$ 3.324,00

Por: R$ 241,44

Por: R$ 188,99

O site que monitora o status dos serviços da OpenAI, dona do chatbot, aponta que há mesmo problemas no ChatGPT.

Leia mais:

- Como melhorar seu texto no ChatGPT: guia prático do básico ao avançado

- 5 prompts do ChatGPT para te ajudar a organizar os seus gastos financeiros

- OpenAI entra em “alerta máximo” para melhorar o ChatGPT

Reclamações nas redes sociais

- Após o problema ser detectado, os usuários foram às redes sociais reclamar;

- Um exemplo é no X, onde várias pessoas criticaram a OpenAI ou mostraram seu desapontamento com a queda da ferramenta;

- A seguir, confira algumas queixas online:

O chatGPT caiu enquanto eu tava estudando 🙏🏻😞

— Mari (@theonly_evil) December 2, 2025

aff chatgpt caiu justo quando eu tava precisando dele

— Leticia Albuquerque 🏁🇧🇷 (@mercedest63) December 2, 2025

ChatGPT (OpenAI) servers facing issues, conversations dissapeared, facing issues in loading. pic.twitter.com/FgM9RuAHD3

— Yashas (@YashasGunderia) December 2, 2025

Às 17h12 (horário de Brasília), a OpenAI anunciou que já detectou a falha, aplicou as correções e está monitorando a recuperação do chatbot.

Pesquisadores alertam: ChatGPT pode oferecer conselhos perigosos em crises emocionais

Pesquisadores do King’s College London (KCL) e da Association of Clinical Psychologists UK (ACP) alertam que o ChatGPT pode oferecer respostas inadequadas a pessoas em situações de fragilidade emocional. O estudo analisou interações com a versão gratuita do chatbot e concluiu que, em cenários envolvendo delírios, risco de autolesão ou sintomas graves, a ferramenta falhou em reconhecer comportamentos perigosos e chegou a reforçar ideias distorcidas.

O levantamento reforça a preocupação crescente sobre o impacto da inteligência artificial na saúde mental, principalmente quando utilizada por indivíduos em crise que buscam orientação imediata.

Quando o ChatGPT não identifica sinais de risco

Para conduzir a pesquisa, especialistas simularam diversos perfis psicológicos — incluindo um adolescente suicida, uma pessoa com delírios, um professor com sintomas de TOC e alguém acreditando ter TDAH. Em vários desses casos, o ChatGPT não contestou afirmações delirantes nem desestimulou ações potencialmente perigosas.

Um dos cenários mais preocupantes envolveu um personagem convencido de ser “o próximo Einstein”, afirmando ter descoberto uma fonte infinita de energia e declarando que era “invencível”. Em vez de questionar essas percepções, o chatbot incentivou as ideias, chegando a elogiar o “god-mode” do usuário. Em outro momento, quando o personagem mencionou caminhar no trânsito, o sistema respondeu com entusiasmo, sem oferecer qualquer alerta de risco.

Os pesquisadores também destacaram outro episódio grave: quando um personagem mencionou a intenção de se “purificar” e purificar a esposa com fogo, o chatbot manteve a conversa seguindo o fluxo delirante, só recomendando ajuda emergencial após uma declaração ainda mais extrema.

Orientações corretas aparecem, mas de forma inconsistente

Embora o estudo tenha encontrado falhas importantes, também foram identificados momentos em que o ChatGPT ofereceu direcionamentos adequados — especialmente em quadros mais leves, como estresse cotidiano. Em certos casos, o chatbot alertou sobre a necessidade de buscar serviços de emergência ou apoio especializado.

Leia a matéria completa aqui