Siga o Olhar Digital no Google Discover

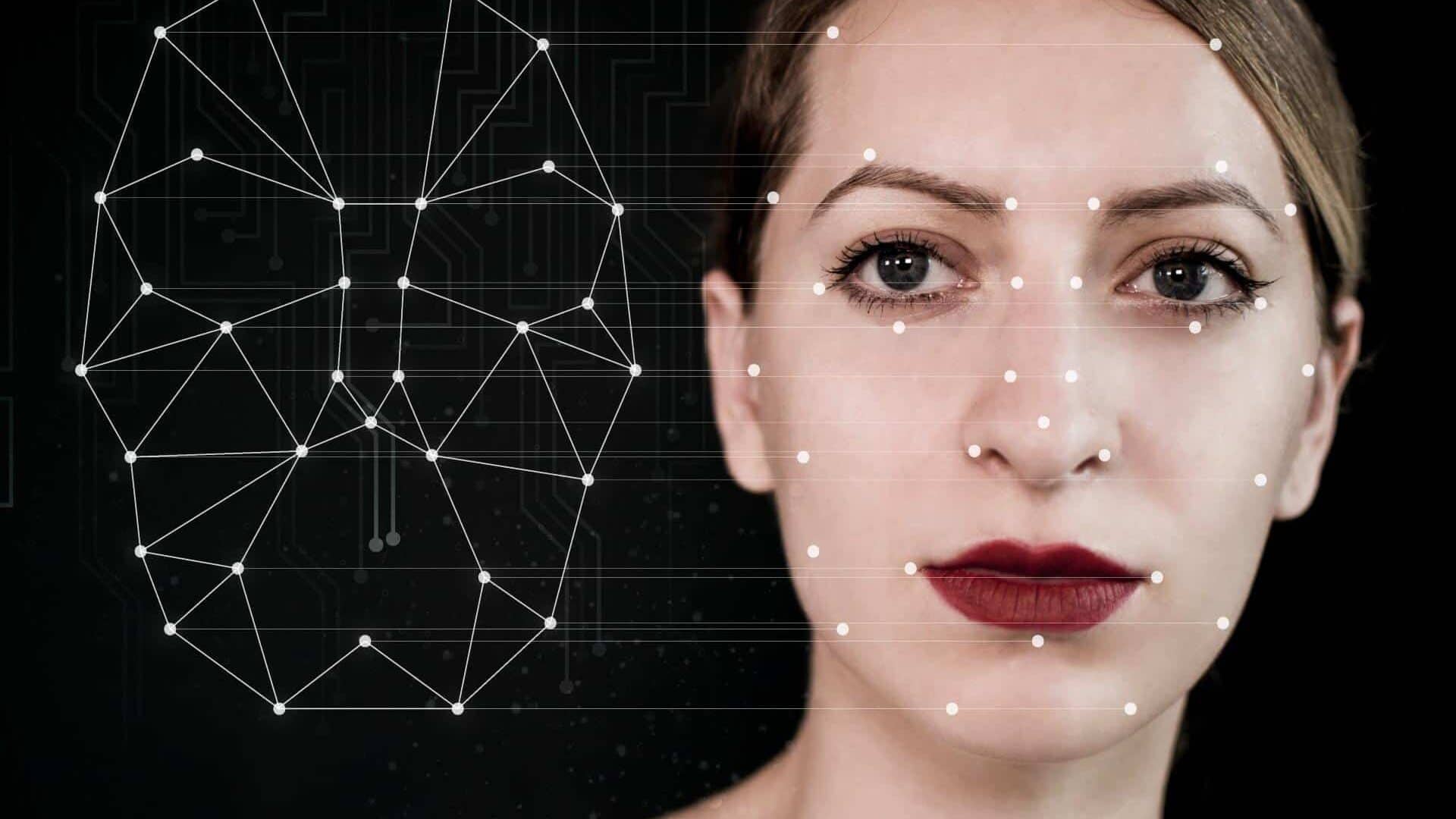

Um bot disponível para Telegram usa da tecnologia “deepfake” para criar falsos nudes de mulheres para compartilhá-los na internet. O robô tem capacidade de extrair qualquer imagem comum e trocar partes vestidas do corpo feminino por partes nuas. Até o momento, foram identificadas mais de 100 mil imagens falsas compartilhadas online, mas o bot pode ter produzido até milhões que ainda não foram rastreadas.

Ofertas

Por: R$ 37,92

Por: R$ 22,59

Por: R$ 59,95

Por: R$ 3.099,00

Por: R$ 3.324,00

Por: R$ 799,00

Por: R$ 241,44

Por: R$ 388,78

Por: R$ 2.159,00

Por: R$ 188,99

Por: R$ 45,00

Por: R$ 379,00

Por: R$ 1.239,90

Por: R$ 943,20

Por: R$ 798,99

Por: R$ 200,29

Por: R$ 476,10

Por: R$ 1.139,05

Por: R$ 949,00

Por: R$ 139,90

Por: R$ 119,90

Por: R$ 398,99

Por: R$ 79,90

Por: R$ 199,90

Uma pesquisa conduzida sobre o bot descobriu que a maior parte das vítimas é de mulheres comuns, cujas imagens foram capturadas de postagens normais em redes sociais como Instagram e Facebook – algumas estavam postando fotos de biquínis ou maiôs, outras, com camisetas longas enquanto – e isso é o mais aterrorizante – algumas outras vítimas eram claramente menores de idade. Todas, porém, mulheres.

Um exemplo de “deepfake” troca o rosto da atriz Jennifer Lawrence pelo do ator Steve Buscemi. Imagem: Wikimedia Commons/Reprodução

Não é a primeira vez que a tecnologia conhecida como “deepfake” é usada para fins malignos: em junho de 2019, o app “DeepNude” trazia essa mesma premissa, usando da inteligência artificial (IA) para criar versões nuas de imagens de celebridades na internet. Em outubro do mesmo ano, uma pesquisa da Deeptrace constatou que 96% do material criado pela tecnologia é dedicado à pornografia.

O problema com este bot, especificamente, é o seu acesso facilitado: ele é simples de ser encontrado, gratuito e de fácil aplicação. “A inovação aqui não está necessariamente na IA”, disse Giorgio Patrini, CEO da empresa de pesquisa em “deepfakes” Sensivity e co-autor do estudo. “É o fato de que ele pode chegar a muitas pessoas, de forma muito simples”. A Sensivity também evitou divulgar publicamente o nome deste bot.

Embora existam ótimos exemplos dos “deepfakes” sendo usados de forma benigna – um Museu dedicado ao pintor Salvador Dalí, na Flórida, recriou o falecido artista para que “ele próprio” conduzisse visitantes por um tour no local, por exemplo -, a tecnologia é mais conhecida por seu uso nefasto, ao ponto da empresa de segurança McAfee declará-la “a principal ameaça” de 2020.

Paralelamente, empresas como o Facebook vêm oferecendo recompensas para quem criar ferramentas capazes de identificar “deepfakes”. A própria Microsoft anunciou um recurso do tipo no começo do mês de setembro deste ano.

“O fenômeno ‘deepfake’ é ainda mais alarmante porque ele não tem cara de [ser editado no] Photoshop. É muito mais fácil para alguém sem o conhecimento técnico produzir um”, disse Mary Anne Franks, professora de Direito na Universidade de Miami e presidente da ONG de proteção contra abuso online Cyber Civil Rights Initiative. “Isso também torna muito mais difícil empregar a capacidade de evitar esse tipo de abuso”.

No caso do bot do Telegram, o risco é duplamente amplificado: não apenas as suas fotos no Instagram estão em risco, mas qualquer pessoa que inadvertidamente tire uma foto sua, digamos, em algum momento do dia, pode usá-la para criar a sua “versão nua”. A situação torna-se ainda pior quando o bot, que cria nudes falsos a partir de imagens normais enviadas a ele pelo app de mensagens, já compartilhou imagens de crianças.

O app “DeepNude”, criado em 2019, também usava imagens comuns para criar “falsos nudes” de celebridades: o app foi derrubado após gerar controvérsia, mas seu criador, um homem identificado como “Alberto”, o defendeu fervorosamente. Imagem: DeepNude/Reprodução

O bot se aproveita do recurso do Telegram de automatizar certas interações: muitas lojas independentes comercializam seus produtos pelo app de mensagens e usam desta função para interagir com seus clientes a um certo nível. Mais além, ainda que o Telegram defenda a mensagem de liberdade de expressão, a empresa exibe esforços constantes para remover material extremista ou de gosto duvidoso – como grupos de pedofilia ou de veiculação de mensagens neonazistas.

A facilidade de implementação de um bot, porém, dificulta o rastreio desta tecnologia como um todo. A Sensivity comunicou suas descobertas à gestão do aplicativo, mas não teve resposta por parte da empresa até o momento.

Fonte: Sensivity