Siga o Olhar Digital no Google Discover

A relação da inteligência artificial (IA) com direitos autorais ainda é área sem regulações e provoca embates entre desenvolvedoras e artistas. Agora, uma nova ferramenta chamada Nightshade permite que os usuários de sistemas de IA que convertem texto em imagem “envenenem” o software para que ele pare de funcionar e gerar resultados satisfatórios.

Ofertas

Vendido por Amazon

meu jogo de pizza dos sonhos pronto: simulador divertido de cozinhar, assar e fazer comida

Por R$ 21,79

Vendido por Amazon

Caderneta s Pastel, Cicero, 6726, Azul, Médio (14X21)

De: R$ 79,99

Por: R$ 50,10

Por: R$ 50,10

Vendido por Amazon

Tilibra - Estojo Triplo Grande Académie Azul

De: R$ 110,90

Por: R$ 67,95

Por: R$ 67,95

Vendido por Amazon

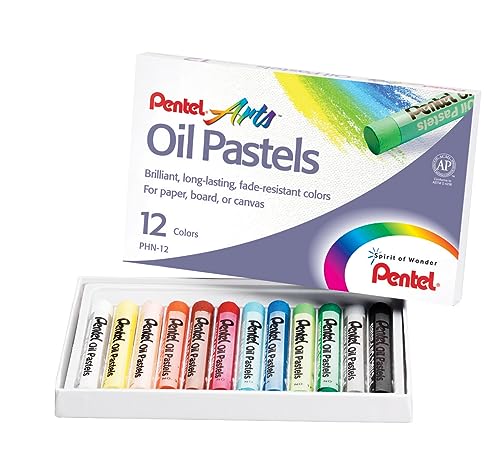

Giz Pastel Oleoso Pentel Arts 12 Cores

De: R$ 17,90

Por: R$ 10,90

Por: R$ 10,90

Vendido por Amazon

GoPro Max 360 - Câmera de Ação à Prova d'água, Vídeo 360 5.6K, Reenquadramento 4K, Foto 360, GPS, Live 1080p, Max HyperSmooth, TimeWarp, Trava de horizonte, Capturas com bastão invisível

De: R$ 2.699,00

Por: R$ 2.069,90

Por: R$ 2.069,90

Vendido por Amazon

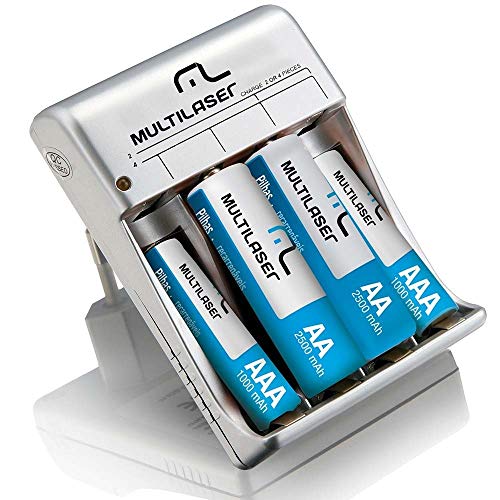

Carregador de Pilhas AA/AAA com 2 Pilhas AA 2500mAh e 2 Pilhas AAA 1000mAh, Multilaser - CB045

De: R$ 89,90

Por: R$ 56,60

Por: R$ 56,60

Vendido por Amazon

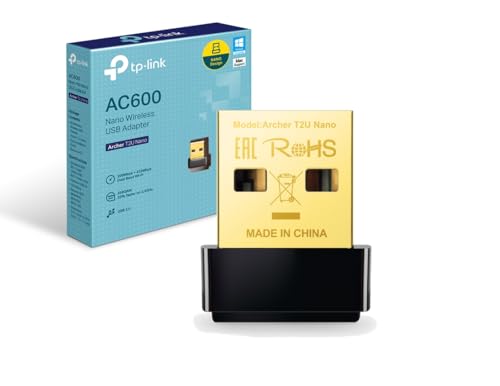

Adaptador Wireless TP-Link Archer T2U Nano USB

De: R$ 109,90

Por: R$ 75,85

Por: R$ 75,85

Vendido por Amazon

SMS - NOBREAK LITE 600 - POTÊNCIA 600VA | 300W - BIVOLT ENT.: 115/ 220V | SAÍDA: 115V - 4 TOMADAS - SENOIDAL P/APROX. - LINE INTERACTIVE - PN 29202

De: R$ 616,58

Por: R$ 334,32

Por: R$ 334,32

Vendido por Amazon

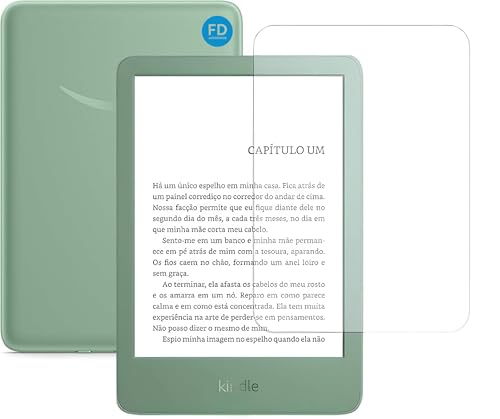

Película Para Kindle 11ª Geração 2024 e 2022 (RS23CV e C2V2L3) 6" Polegadas - Antirreflexo - Fosca – FD Acessórios

Por R$ 23,83

Vendido por Amazon

Drone DJI Air 3S Fly More Combo (Com tela) BR - DJI056

De: R$ 17.375,50

Por: R$ 15.522,79

Por: R$ 15.522,79

Vendido por Amazon

USB C Hub 8 em 1 USB Tipo C para HDMI 4k RJ45 Ethernet Carregamento PD Charger, 2 portas USB 3.0 e leitor de cartões SD/TF, compátivel com Macbook, tablets,celulares-Thee Brothers

De: R$ 57,90

Por: R$ 49,90

Por: R$ 49,90

Vendido por Amazon

PHILIPS, Fone de Ouvido Sem Fio TWS, TAT2500BK/00, Bluetooth, Com Cancelamento de Ruído Ativo ANC, Com Microfone, Até 24 horas de bateria, iPX4, Preto

De: R$ 156,00

Por: R$ 140,00

Por: R$ 140,00

Vendido por Amazon

Microfone USB Gaming PC, Microfone RGB para PC/Notebook, Mic with Boom Arm, Microphone Condensador de mesa/Braço, Live, Podcast, Gravação de Audio, Karaoke, Gamer Youtuber DJ

De: R$ 199,99

Por: R$ 178,49

Por: R$ 178,49

Vendido por Amazon

Relógio Inteligente Smartwatch Feminino Masculino, com Tela AMOLED, AI ChatGPT, Chamadas Bluetooth, 150+ Monitoramento Esportivo, Chamadas Bluetooth,Relogio smartwatch iphone

Por R$ 299,99

Vendido por Amazon

soundcore Q11i da Anker Fone De Ouvido Bluetooth 5.3, Fone Gamer, Headphone Bluetooth Over-Ear, Graves Profundos, 60H Autonomia, Hi-Res Áudio, Almofadas Removíveis, Conexão Multiponto, Preto

De: R$ 259,35

Por: R$ 198,99

Por: R$ 198,99

Vendido por Amazon

Bundle Nintendo Switch + Super Mario Bros. Wonder + 3 Meses de Assinatura Nintendo Switch Online

Por R$ 2.399,00

Vendido por Amazon

Notebook ASUS TUF Gaming A15, RTX 3050, AMD RYZEN 7, 8 GB, 512 GB SSD, KeepOS, Tela 15.6'' FHD, Graphite Black - FA506NCR-HN089

De: R$ 5.299,00

Por: R$ 3.999,00

Por: R$ 3.999,00

Vendido por Amazon

Havit Headphone Fone de Ouvido H2002d Pink, Gamer, com Microfone, Falante 53mm, Plug 3, 5mm: compatível com XBOX ONE e PS4, HAVIT, HV-H2002d Cor Rosa

De: R$ 229,00

Por: R$ 160,65

Por: R$ 160,65

Vendido por Amazon

Roku Streaming Stick HD 2025 | Dispositivo de streaming para TV HD/FHD com controle remoto por comando de voz compatível com Alexa, Siri e Google

De: R$ 289,90

Por: R$ 187,00

Por: R$ 187,00

Vendido por Amazon

EMEET Webcam 4K, webcam S600 com tripé, 2 microfones de redução de ruído, FOV ajustável de 40° a 73°, foco automático PDAF, capa de privacidade integrada, câmera de streaming para jogos, chamadas de

Por R$ 419,99

Vendido por Amazon

soundcore P30i by Anker, Fones de Ouvido com Cancelamento de Ruído, Graves Poderosos, 45H de Reprodução, Estojo 2-em-1 com Suporte para Celular, IP54, Bluetooth 5.4, Fones Sem Fio

De: R$ 369,00

Por: R$ 209,90

Por: R$ 209,90

Vendido por Amazon

soundcore P20i da Anker Fone de Ouvido Sem Fio, Drivers de 10mm, Graves Potentes, Bluetooth 5.3, 30H de Bateria, Resistência à Água, 2 Microfones IA, App Personalizável

De: R$ 249,00

Por: R$ 166,19

Por: R$ 166,19

Vendido por Amazon

HD Externo Toshiba 1TB Canvio Basics Preto HDTB510XK3AA

De: R$ 464,65

Por: R$ 330,00

Por: R$ 330,00

Veneno

- O Nighshade funciona de forma simples: basta que os usuários desses softwares de IA o anexem ao seu pedido e ele corromperá o programa.

- Um dos exemplos disso é como ela pode alterar a visualização dos pixels da imagem final ou fazer com que o chatbot leia um objeto como algo completamente diferente, entregando resultado inesperado.

- Segundo o The Verge, isso pode desconfigurar as configurações de softwares, como DALL-E, Stable Diffusion e Midjourney e, a longo prazo, limitar a capacidade de criar imagens artificiais.

Leia mais:

- OpenAI cria equipe para estudar riscos ‘catastróficos’ da IA

- Midjourney: entenda o que é e como produzir imagens com inteligência artificial

- ChatGPT com problemas? Veja como resolver

Artistas vs. IA

- Um professor da Universidade de Chicago, Ben Zhao, é um dos criadores do Nighshade e disse ao MIT Technology Review que a intenção do “veneno” é desviar a balança das empresas de IA que utilizaram obras com direitos autorais para treinar modelos de linguagem;

- Ainda, o artigo de pesquisa do Nightshade mostra como softwares de conversão de texto em imagem são vulneráveis a ataques, que podem desestabilizar os programas e tirar sua capacidade de geração;

- Para intensificar a situação, o Nightshade está integrado ao Glaze, ferramenta dos mesmos criadores que mascara o estilo de arte de artistas, para que a IA não possa reproduzi-las;

- Esses criadores propuseram no artigo que esses programas “hackers” poderiam, em última instância, ser usados como defesa dos artistas contra as empresas de IA que se aproveitam de seus trabalhos.