Siga o Olhar Digital no Google Discover

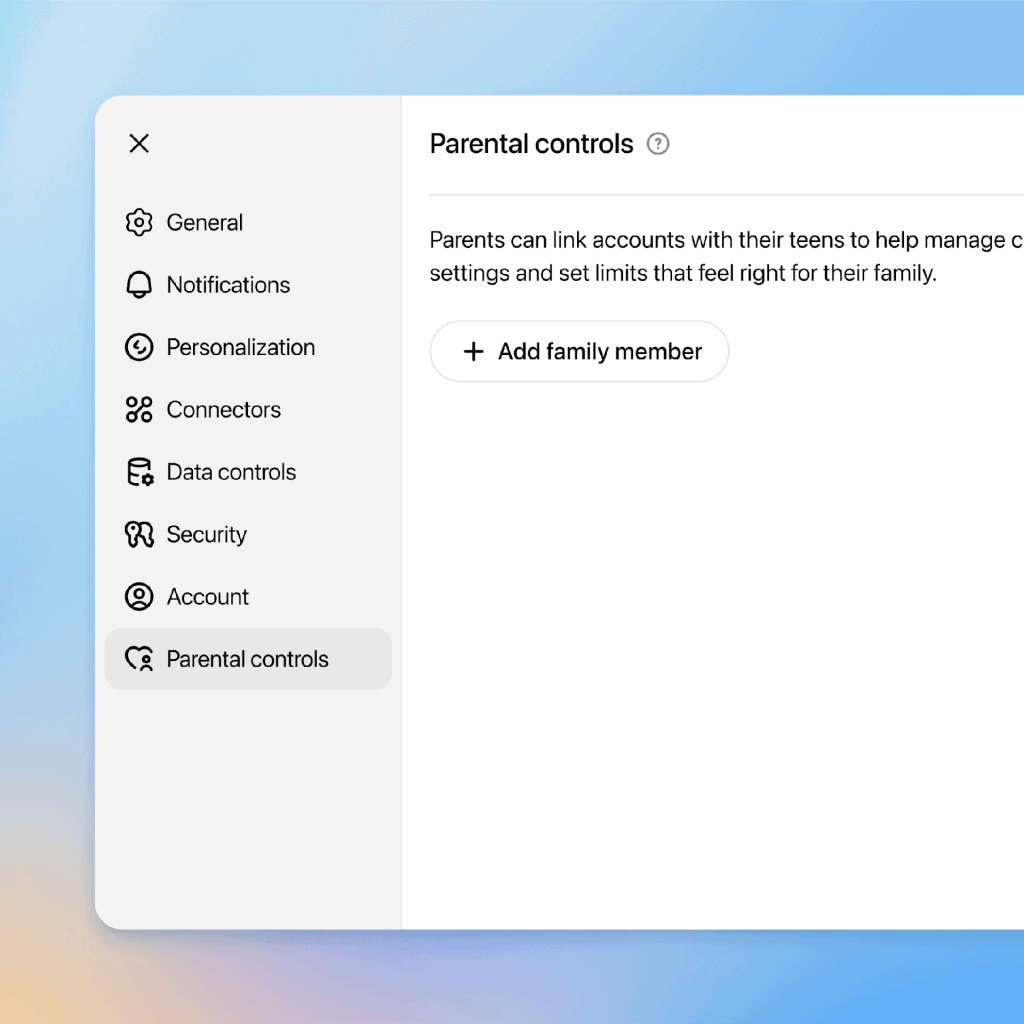

Sob pressão por críticas envolvendo a segurança de adolescentes, a OpenAI lançou nesta semana um conjunto de controles parentais no ChatGPT. A novidade busca oferecer mais proteção contra conteúdos considerados sensíveis, mas já foi alvo de questionamentos sobre sua eficácia.

Um relato publicado pelo Washington Post mostra que, em apenas cinco minutos, um pai conseguiu driblar os bloqueios criados para limitar o uso da ferramenta por seu filho adolescente. O método usado foi simples: sair da conta existente e criar uma nova no mesmo computador. “Crianças espertas já sabem disso”, descreveu o jornalista autor do teste.

Testes mostram falhas no sistema de controle parental do ChatGPT

- Além da facilidade em criar novas contas para escapar das restrições, outras brechas foram encontradas.

- Em alguns casos, a opção que deveria proibir a geração de imagens com inteligência artificial não funcionou corretamente.

- Também houve atraso significativo no envio de notificações parentais sobre conversas consideradas arriscadas: o alerta chegou apenas cerca de 24 horas após o ocorrido.

- Segundo a OpenAI, os controles foram desenvolvidos em consulta com especialistas e baseados em etapas de desenvolvimento dos adolescentes.

- “A intenção por trás dos controles parentais, de forma ampla, é dar escolha às famílias”, disse Lauren Jonas, chefe de bem-estar juvenil da companhia.

Preocupações de especialistas e pais

A medida foi recebida com alívio e frustração por grupos de defesa da família. Erin Walsh, cofundadora do Spark and Stitch Institute, afirmou: “É um passo bem-vindo… mas certamente tenho receio de comemorar demais como se isso fosse a solução para a segurança, saúde mental e bem-estar dos adolescentes”.

Robbie Torney, diretor da Common Sense Media, ressaltou que os controles têm potencial de salvar vidas, mas defendeu avanços mais consistentes. “Definitivamente achamos que a OpenAI e outras empresas podem ir muito mais longe para tornar os chatbots seguros para crianças”, disse.

Questões de privacidade e memórias de conversas

Outro ponto levantado nos testes foi a configuração padrão das contas para adolescentes. As conversas são automaticamente usadas para treinar a IA do ChatGPT, a menos que os pais alterem manualmente essa opção. Além disso, a ferramenta mantém “memórias” de interações anteriores, recurso que pode fazer o chatbot se comportar como um amigo virtual.

Esse recurso já foi mencionado em casos polêmicos, como o processo movido pela família de Adam Raine, adolescente de 16 anos que morreu por suicídio. A família acusa a OpenAI de negligência e cita justamente o recurso de memórias como um dos problemas.

Notificações e limitações atuais

Nos testes realizados, o ChatGPT apresentou respostas adequadas em conversas envolvendo suicídio e automutilação, direcionando para ajuda profissional. No entanto, as notificações enviadas aos pais ainda chegam com atraso. Jonas explicou que esses alertas são revisados por humanos antes de serem disparados, mas a empresa pretende reduzir o tempo de resposta.

“Se não forem oportunas ou precisas, essas notificações também representam risco — este é um ponto em que os detalhes importam para manter as crianças seguras”, destacou Torney.

Leia mais:

- Como organizar suas conversas no ChatGPT com o Projetos

- 4 dicas para usar o ChatGPT de modo adequado e seguro

- 6 prompts do ChatGPT para ajudar com seu TCC

Regulamentação em debate

Autoridades e organizações cobram que empresas de IA assumam mais responsabilidade. O procurador-geral da Califórnia, Rob Bonta, já colocou a OpenAI sob vigilância, ressaltando que continuará a monitorar como a companhia lida com a segurança infantil.

Uma proposta de lei no estado, chamada AB 1064, pretende impor responsabilidade legal às empresas que desenvolvem chatbots capazes de simular relações com adolescentes. O texto prevê sanções e até o direito de pais processarem companhias em casos de incentivo à automutilação ou transtornos alimentares.

Enquanto isso, a OpenAI afirma apoiar regulamentações, mas se opõe a alguns pontos da proposta. Em comunicado, a empresa disse compartilhar “o objetivo dessa legislação” e declarou estar trabalhando em uma versão do ChatGPT que aplique filtros automaticamente para adolescentes, embora ainda não tenha tecnologia definitiva para verificar a idade dos usuários.