Siga o Olhar Digital no Google Discover

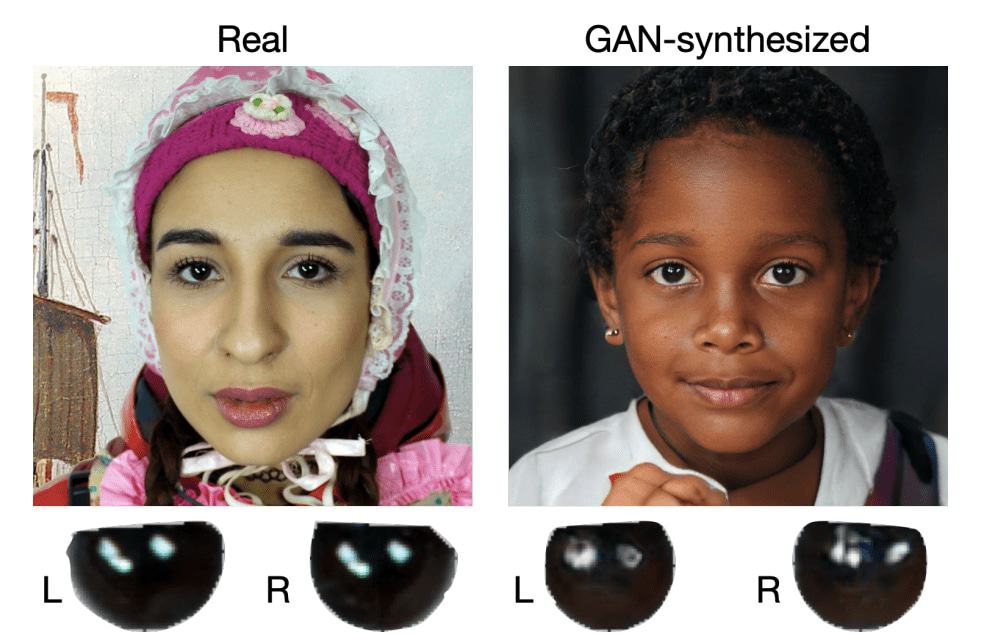

Uma nova ferramenta usa a inteligência artificial (IA) para detectar deepfakes gravados em vídeo pelo reflexo da luz nos olhos de seus personagens. O sistema, criado por especialistas da Universidade de Buffalo, teve 94% de exatidão em encontrar vídeos falsos feitos em modo retrato.

Ofertas

Por: R$ 4.460,93

Por: R$ 3.099,00

Por: R$ 3.324,00

Por: R$ 799,00

Por: R$ 241,44

Por: R$ 388,78

Por: R$ 2.159,00

Por: R$ 188,99

Por: R$ 45,00

Por: R$ 379,00

Por: R$ 1.239,90

Por: R$ 798,99

Por: R$ 199,00

Por: R$ 476,10

Por: R$ 1.139,05

Por: R$ 949,00

Por: R$ 155,44

Por: R$ 119,90

Por: R$ 398,99

Por: R$ 79,90

Por: R$ 222,11

A ferramenta de IA analisa a córnea das pessoas presentes nos vídeos, determinando serem reais ou deepfakes. Essa parte do olho tem um aspecto quase espelhado, que reflete a luz que incide sobre ela. Em um vídeo real, ambos os olhos terão mais ou menos o mesmo reflexo, considerando que a pessoa estará enxergando o mesmo objeto. Em um vídeo falso, esse padrão não é fielmente reproduzido uma vez que o material é gerado por computador.

Leia mais:

- Deepfakes: mulher é presa nos EUA por prejudicar rivais da filha

- Criador de deepfakes com Tom Cruise diz que tecnologia de falsificação ainda engatinha

- Autoridades italianas vão investigar bot do Telegram que produz nudes

Desde seu nascimento, os deepfakes levantaram questões bastante necessárias devido aos seus potenciais problemas de segurança. Mas a tecnologia também já foi aplicada de forma benéfica: um museu na Flórida, dedicado à vida e obra do pintor surrealista Salvador Dalí, coloca o próprio artista (que faleceu em dezembro de 1989) para comandar o tour dos visitantes. Entretanto, os deepfakes tornaram-se mais conhecidos pelo seu lado maléfico: com eles, é possível inserir o rosto de qualquer pessoa, por exemplo, em um filme pornográfico.

Processo ainda depende de alguns fatores

Em 2020, uma ferramenta usava a tecnologia deepfake para “adivinhar” como seria o corpo nu de uma pessoa a partir de uma foto de biquíni, gerando “falsos nudes”, o que obviamente traz preocupações de constrangimento e privacidade para especialistas em segurança trabalharem em cima.

O sistema da Universidade de Buffalo mapeia os rostos e olhos das pessoas presentes nos vídeos, procurando por essas discrepâncias do reflexo da luz nas córneas e íris. As diferenças podem variar desde formas geométricas aleatórias até o posicionamento e ângulo errados, no caso de vídeos falsos. A partir daí, a ferramenta estabelece uma pontuação numérica: quanto mais baixo for o valor, maior a chance do vídeo ser falso.

Os cientistas, porém, reconhecem que há falhas no método empregado. Não bastasse ele funcionar apenas em vídeos gravados em modo retrato (quando você filma com o seu celular em pé, por exemplo), ele ainda depende de uma fonte de luz constante e também que ambos os olhos estejam visíveis para a captura. Qualquer coisa que fuja desse padrão fará com que o sistema, embora funcione normalmente, apresente falsos positivos.

Agora, o time da Universidade de Buffalo vai trabalhar justamente para aprimorar essas falhas e atualizar o recurso, o que pode levar um bom tempo e muita pesquisa.

Fonte: The Next Web