Siga o Olhar Digital no Google Discover

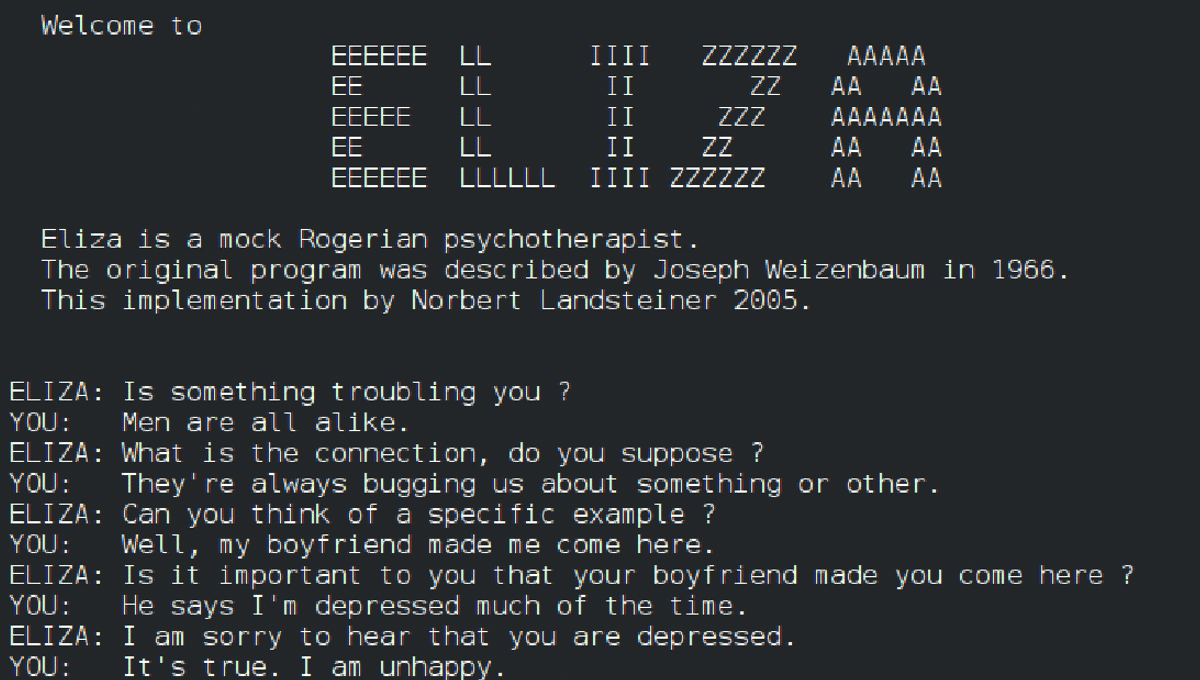

Com o avanço da robótica e da Inteligência Artificial, os robôs têm se tornado cada vez mais inteligentes. Em 1965, porém, Eliza, um robô desenvolvido pelo Instituto de Tecnologia de Massachusetts (MIT), só fingia e usava truques para enganar as pessoas.

Ofertas

Por: R$ 37,92

Por: R$ 22,59

Por: R$ 59,95

Por: R$ 3.099,00

Por: R$ 3.324,00

Por: R$ 799,00

Por: R$ 241,44

Por: R$ 349,90

Por: R$ 2.159,00

Por: R$ 188,99

Por: R$ 45,00

Por: R$ 379,00

Por: R$ 1.239,90

Por: R$ 943,20

Por: R$ 798,99

Por: R$ 205,91

Por: R$ 476,10

Por: R$ 1.139,05

Por: R$ 949,00

Por: R$ 7,60

Por: R$ 21,77

Por: R$ 16,63

Por: R$ 59,95

Por: R$ 7,20

Por: R$ 139,90

Por: R$ 119,90

Por: R$ 398,99

Por: R$ 79,90

Por: R$ 199,90

Leia mais:

- ChatGPT em “carne e osso”: OpenAI investe em robô humanoide

- O que é ChatGPT e como acessar a inteligência artificial em português

- O que você precisa saber antes de comprar um aspirador robô

Eliza, o primeiro robô

Eliza foi o primeiro robô de conversação (o que chamaríamos hoje de chatbot). O modelo foi desenvolvido pelo matemático Joseph Weizenbaum, pesquisador do MIT, para funcionar como uma espécia de psicóloga. Isso foi em 1965, mais de uma década antes da popularização dos computadores pessoais, na década de 1980.

Na prática, o pesquisador criou um software capaz de identificar cerca de 250 tipos de frases. Assim, ela enganava o usuário incorporando trechos das próprias perguntas nas respostas.

Para Rodrigo Siqueira, engenheiro elétrico, administrador e fundador da empresa Inbot, que desenvolve chatbots com processamento de linguagem natural, o robô se utilizava de truques.

A Eliza usava uma série de truques para parecer que era inteligente e o usuário se esquecia de que estava conversando com um computador.

Rodrigo Siqueira, em entrevista ao Valor Econômico

Novas tecnologias

- A “mãe dos robôs” pode não ser avançada como as tecnologias que conhecemos hoje, mas seu mecanismo de identificação de palavras-chave ainda é usado em robôs de conversação mais simples atualmente.

- Agora, eles foram evoluindo com novas camadas de programação e podem, por exemplo, identificar erros ortográficos.

- O ChatGPT é um dos que foi além e consegue identificar sentimento do usuário.

- Siqueira explica que, com o tempo, os mecanismos foram refinados para entender a intenção do interlocutor e formular respostas que possam se aproximar mais da que ele espera.

- Um exemplo disso é a confiança com que o ChatGPT passa informações falsas — algo que a OpenAI prometeu mitigar na versão 4.0.

- Rodrigo Siqueira destaca a “alucinação da IA” e diz que uma das soluções usadas pela Inbot é treinar a ferramenta para reconhecer que não sabe todas as respostas.

Com informações de Valor Econômico

Já assistiu aos novos vídeos no YouTube do Olhar Digital? Inscreva-se no canal!